“在文生图领域,开源(模型)和闭源的差距是逐渐拉大的,希望我们的开源能把这个差距缩小。”

5月14日下午,腾讯宣布最新混元文生图大模型对外开源,该产品负责人芦清林在一场小型沟通会上对界面新闻等媒体如是说。

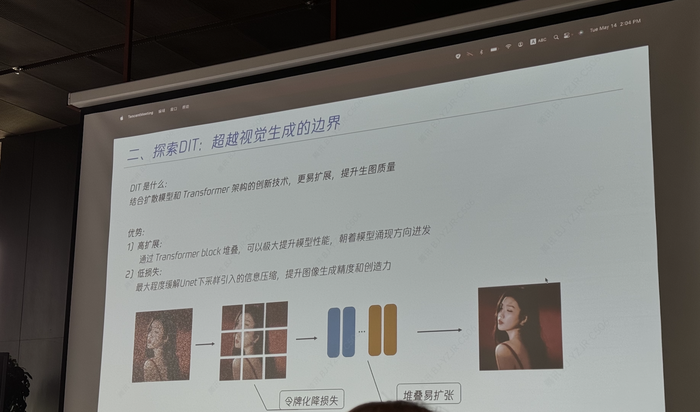

据腾讯方面介绍,上述大模型是业内首个中文原生的DiT(Diffusion With Transformer)架构文生图开源模型,支持中英文双语输入及理解,参数量为15亿(1.5B)。DiT的核心思想是将Transformer架构应用于扩散模型中,以此来提高生成图像的质量和效率。

该模型采用的DiT架构与Open AI的革命性产品Sora保持一致,不仅可支持文生图,也可作为视频等多模态视觉生成的基础。目前其已在专注于自然语言处理(NLP)的开源机器学习平台Hugging Face及面向软件开发者的代码托管平台Github上发布,包含模型权重、推理代码、模型算法等完整模型,可供企业与个人开发者免费商用。

若以腾讯方面提供的评测数据来看,其效果超过开源的Stable Diffusion模型,整体能力走在前列。

“我们还会尝试参数量更大的模型,它消耗的计算资源和时长会更长。”芦清林称,“虽然还没ready(准备好),但已经在做。”

本次混元文生图大模型升级的重点在于采用全新的DiT架构,在这方面混元与Sora和Stable Diffusion 3保持了一致性,都是基于Transformer架构的扩散模型,它的优点是对大参数量更加友好。

摄影:崔鹏

摄影:崔鹏

过去,视觉生成扩散模型主要基于U-Net架构,会先将图片压缩,然后再重新放大,但这个过程通常会伴随信息损失。随着参数量提升,这个架构的训练稳定性也在逐渐变差,使用它的模型正在变少。

芦清林表示,基于Transformer架构的扩散模型网络结构,避免了信息的压缩处理,能显著提高模型的生成质量及效率。

新架构的语意表达能力更强,可容纳的信息量更多,也能适应更大规模的参数量,“未来升级到5B甚至10B时,我们都有把握将大模型训练得更加合理。”芦清林强调。

据界面新闻了解,早在2023年7月前后,腾讯团队就明确了基于DiT架构的模型方向,启动新一代模型研发,但当时国内少有产品尝试此方向。

今年初,混元文生图大模型升级为DiT架构,在这个过程中,腾讯也对原有模型进行了部分改进。比如,在算法层面优化了模型的长文本理解能力,能够支持最多256字符的内容输入。

此前Stable Diffusion等主流开源模型核心数据集以英文为主,混元文生图则强调是中文原生的DiT模型,具备中英文双语理解及生成能力。

芦清林告诉界面新闻,过去很多大模型都是把国外的数据做一层翻译,再变成中文进行训练,在这个过程中会造成很多信息损失和理解歧义。而混元文生图大模型支持的是原生中文理解能力,砍掉翻译过程,用户可直接使用中文数据进行训练,大模型理解的也是中文。

腾讯展示的评测结果显示,新的文生图大模型视觉生成整体效果较前代提升超过20%,在语义理解、画面质感与真实性方面提升明显。

同时,混元还实现了多轮生图和对话能力,用户能在一张初始生成图片的基础上,通过自然语言描述进行调整。

在芦清林看来,多轮对话本质上是大语言模型不停在用户和chatbox(AI聊天机器人)之间做交互,用户不需要一上来就提供完整的提示词,可以一边写一边改一边生成(图片),觉得不满意再改再生成,极大降低了使用门槛。

据界面新闻了解,混元文生图大模型去年主要在与腾讯广告进行合作,搭建广告场景下的AI驱动工具,今年则计划加大与QQ、企业微信和游戏等业务的合作,在更多的业务场景中大规模落地应用。

芦清林强调,目前混元文生图大模型的开源版本,也是腾讯内部正在使用的版本,不存在自用的领先几代,给业界放出来会落后的问题。

实际上,它已经在腾讯内部被用于素材创作、商品合成和游戏出图等众多场景。比如在今年初,腾讯广告就基于混元大模型,推出一站式AI广告创意平台,可以为广告主提供文生图、图生图与商品背景合成等工具。

过去混元文生图大模型走的路线也是闭源,内部将大模型迭代后,再将接口开放出来使用。现在团队发现,做开源社区能让更多开发者参与进来,共建的方式有助于大模型走得更快。

“去年7月开始转型(DiT架构),我们踩了非常多的坑,直到今年1月份才逐步把问题解决掉。”芦清林认为,此时选择开源是一个合适的时机,基于开源模型,企业无需重头训练,即可直接用于推理,能够节约大量人力和算力。

今年春节期间Open AI放出Sora之后,芦清林说团队“年都没过好”,对方已经证明了DiT架构的强大能力,“我们希望把图片的DiT分享出来,让业界想做视频的同行可以快速跟进追赶。”

在选择开源之前,腾讯也在内部做了横向对比测试,结论是在图文一致性、美学、清晰度等对比维度上,混元与主流闭源模型相比差距不算太大,能排在Dalle 3和SD 3(Stable Diffusion 3)之后。

此外,目前的文生图开源社区主要还是Stable Diffusion等为主的英文开源社区,腾讯选择开源后,能丰富以中文为主的文生图开源生态,形成更多样的原生插件,推动中文文生图技术研发和应用。

混元文生图大模型的开源,也是腾讯推进开源战略的一部分。根据官方给出的统计,腾讯目前已经开源了超过170个项目,且都基于真实的业务场景,覆盖微信、腾讯云和腾讯游戏等核心业务。

转载来源:界面新闻 作者:崔鹏CP

京公网安备 11010802028547号

京公网安备 11010802028547号